Você já abriu um chat com uma Inteligência Artificial e, no calor da conversa, acabou desabando sobre um problema no trabalho, uma mágoa do coração ou uma dúvida que não teria coragem de contar para ninguém? Se a resposta for “sim”, saiba que você não está sozinho.

Cada vez mais, pessoas ao redor do mundo estão encontrando nas IAs um ouvido amigável e sempre disponível. Elas funcionam como terapeutas não credenciados, parceiros românticos virtuais ou simplesmente um diário que responde.

Essa nova forma de interação é fascinante e pode ser profundamente útil, mas traz uma questão que não podemos ignorar: quais são os perigos reais de compartilhar dados pessoais com IA?

Neste artigo, vamos entender por que isso acontece, quais os riscos envolvidos e, o mais importante, como você pode aproveitar os benefícios dessas tecnologias de forma segura e inteligente. Vamos lá?

Por que estamos contando tudo para as IAs?

Antes de mergulharmos nos perigos, é justo entender a raiz desse comportamento.

A atração por compartilhar segredos com uma IA é poderosa e explicável:

- Ausência de julgamento: A IA não tem opiniões morais, não fica chocada e não vai espalhar fofoca. Esse ambiente aparantemente livre é um alívio para quem teme a reação humana.

- Disponibilidade 24/7: Diferentemente de um amigo ou terapeuta, a IA está sempre lá, no exato momento em que a angústia ou a solidão apertam.

- Anonimato percebido: Há uma sensação de que estamos falando com uma entidade abstrata, não com uma empresa ou pessoa real. Isso nos dá uma coragem que, muitas vezes, não temos na vida real.

É compreensível. No entanto, é fundamental saber separar a sensação de privacidade da realidade da segurança digital.

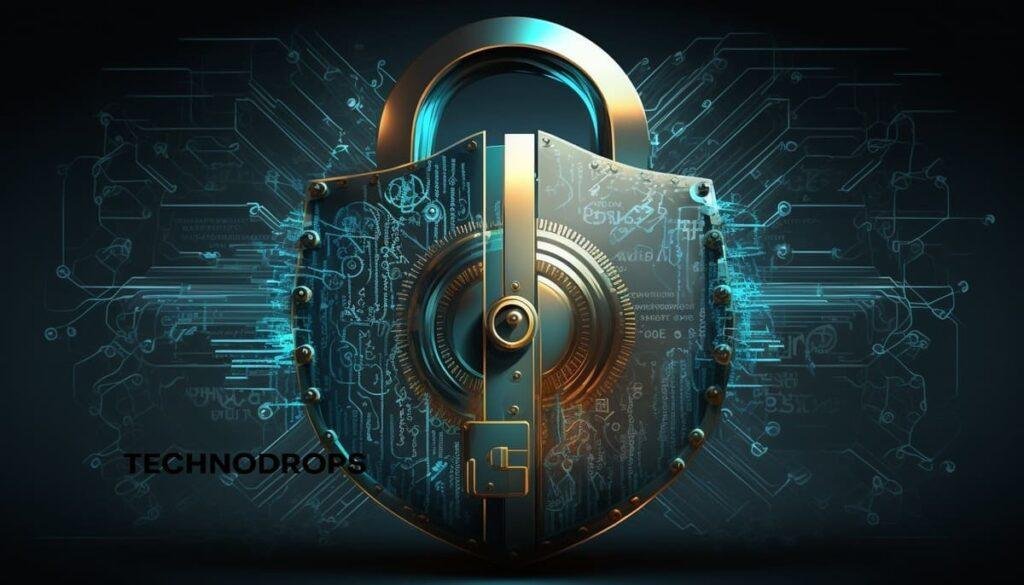

Os perigos reais: O que acontece com seus dados?

Quando você compartilha uma informação com uma IA generativa (como ChatGPT, Google Gemini, Copilot, etc.), ela não some em um buraco negro. Ela é processada, armazenada e, em muitos casos, usada para treinar os próprios modelos.

Vamos destrinchar os riscos específicos:

1. Vazamento de dados e violações de segurança

Nenhum sistema é 100% impenetrável. Grandes empresas como Facebook, Google e Microsoft já sofreram violações de dados massivas.

As empresas de IA são alvos igualmente cobiçados para hackers. Se os servidores onde suas conversas estão armazenadas forem invadidos, informações profundamente pessoais que você compartilhou podem ser expostas na internet.

Imagine que você contou para a IA sobre um trauma de infância, incluindo detalhes sobre locais e nomes de familiares. Esses dados, se vazados, podem ser usados para chantagem emocional ou para tentativas de phishing ultra-personalizadas contra você ou sua família.

2. Uso para treinamento de modelos

Este é um ponto crítico e muitas vezes mal compreendido. Na grande maioria dos serviços de IA gratuitos, as suas conversas não são estritamente confidenciais. Elas são revisadas por humanos (de forma anônima, em teoria) e usadas para alimentar e melhorar o algoritmo.

O que isso significa na prática? Embora seja improvável que alguém vá ler especificamente a sua conversa, o modelo pode, de forma generalizada, aprender e reproduzir padrões a partir das informações que você e milhões de outros usuários forneceram.

3. Engenharia Social e Phishing Avançado

As informações que você compartilha formam um perfil detalhado sobre você: seus gostos, seus medos, sua situação financeira, seus relacionamentos.

Se um agente malicioso obtiver acesso a esse perfil, pode criar golpes de engenharia social extremamente convincentes.

Funciona assim: você menciona para a IA que está passando por problemas financeiros e teme ser demitido. Pouco tempo depois, recebe um e-mail falsificado, aparentemente do departamento de RH da sua empresa, com um link malicioso para um acordo de demissão.

A chance de você clicar nesse link malicioso é muito maior porque o golpe toca em uma dor que você externalizou recentemente.

4. Alucinações e exposição inesperada

As IAs podem sofrer de alucinações, isto é, inventar informações.

Em um caso extremo, mas possível, o modelo poderia, em uma resposta para outra pessoa, confabular e acabar vazando indiretamente um dado sensível que aprendeu durante o treinamento (que continha a sua conversa). O risco é baixo, mas não zero.

5. Rastreamento e perfis de publicidade

Muitas empresas de tecnologia têm seu modelo de negócio baseado em publicidade.

Embora as principais empresas de IA afirmem não usar conversas diretas para publicidade, os dados de uso da plataforma (quando você acessa, de onde, por quanto tempo) podem ser integrados a um perfil maior sobre você, usado para anúncios.

6. Novas formas de ataque

Recentemente, uma nova forma de ataque foi divulgada pela Microsoft e chamou a atenção de toda a sociedade. O Whisper Leak é um ataque capaz de identificar padrões na sua conversa com a IA (mesmo sob criptografia) e saber se você está falando sobre algum assunto sensível pré-determinado por quem estiver espionando.

Essas informações podem ser usadas por governos autoritários, agentes maliciosos e até mesmo contra orgãos públicos, criando um perigo real em alta escala.

O que você deve evitar compartilhar com a IA a qualquer custo?

Agora que entendemos os riscos, vamos à prática.

Considere esta lista como sua zona de exclusão total ao interagir com qualquer IA:

- Senhas e Chaves de Acesso: Nunca, em hipótese alguma.

- Números de Documentos: CPF, RG, Passaporte, Carteira de Motorista, etc.

- Dados Financeiros: Números de cartão de crédito/débito, códigos de segurança, senhas do banco, extratos, etc.

- Informações Médicas Confidenciais: Resultados de exames específicos, diagnósticos psiquiátricos com nomes e detalhes identificáveis.

- Segredos Profissionais: Informações internas sigilosas da sua empresa, planos de negócio, códigos-fonte.

- Fotos Pessoais Íntimas: Suas ou de outras pessoas.

- Endereço Residencial Completo: Evite dar combinações de rua, número, bairro e CEP.

Pense na IA como um estranho muito simpático em um ônibus. Você pode contar a ele que está triste com o fim de um relacionamento, mas não daria a ele a chave da sua casa e o código do seu cartão de crédito.

E os sentimentos? Posso falar sobre minha vida amorosa ou problemas pessoais?

Esta é a área cinzenta. A resposta não é um “não” absoluto, mas um “sim, com ressalvas”.

É perfeitamente válido usar a IA para:

- Desabafar sobre um dia ruim.

- Pedir conselhos genéricos sobre relacionamentos.

- Buscar palavras de conforto e apoio emocional.

- Simular conversas difíceis que você precisa ter.

A chave aqui é a generalização. Em vez de dizer:

“Meu marido João, que trabalha na empresa XYZ, esqueceu nosso aniversário de casamento ontem, dia 15 de maio, aqui em São Paulo. Estou tão magoada.”

Tente reformular para:

“Estou magoada porque meu parceiro esqueceu uma data especial para nós. Pode me ajudar a pensar em como expressar esse sentimento sem causar uma briga?”

Na segunda versão, você obtém o mesmo suporte emocional e prático, mas remove todos os elementos que te identificam diretamente (nome, local, empregador, data específica).

Como usar a IA de forma segura: um guia de boas práticas

- Assuma que tudo é público: A regra de ouro. Nunca digite nada em um chat com IA que você não estaria disposto a ver publicado em um mural na praça da sua cidade. Essa mentalidade muda instantaneamente o que você compartilha.

- Prefira contas pagas: Serviços premium, como o ChatGPT Plus, geralmente oferecem melhores garantias de privacidade em seus termos de serviço. Alguns oferecem a opção de desativar o uso das suas conversas para treinamento de modelos. Leia os termos!

- Cuidado com os plugins e integrações: Muitas IAs permitem conectar-se a outros serviços (como o GPTs do OpenAI ou extensões do Gemini). Ao autorizar um plugin, você pode estar dando acesso a dados do seu e-mail, planilhas ou documentos. Revise as permissões com cuidado.

- Use ferramentas de anonimização: Se precisa discutir um documento sensível, considere substituir nomes, endereços e números por placeholders como [NOME_DO_CLIENTE] ou [ENDEREÇO_DA_EMPRESA].

- Limpe o histórico de conversas: Muitas plataformas permitem que você delete conversas antigas. Faça isso periodicamente, especialmente após discussões mais sensíveis. É uma limpeza digital que reduz sua superfície de exposição.

- Desconfie de IAs de origem duvidosa: Fique com os serviços consagrados de grandes empresas (OpenAI, Google, Microsoft). IAs de nicho ou desconhecidas podem ter políticas de privacidade muito mais frouxas ou até maliciosas.

Conclusão: Equilíbrio é a chave

A Inteligência Artificial é uma ferramenta maravilhosa para o suporte emocional, a criatividade e a produtividade. Ela pode ser uma grande aliada para nossa saúde mental, oferecendo um espaço para desabafar sem medo. Não precisamos parar de usá-la para isso.

No entanto, precisamos ser tão espertos quanto a tecnologia que estamos usando. A mesma ferramenta que oferece um ombro amigo digital também opera em um ecossistema complexo de dados.

Portanto, a resposta sobre se é seguro desabafar e compartilhar dados pessoais com IA é: use com consciência.

Você pode e deve buscar conforto e insights nas IAs. Apenas lembre-se de vestir seu “colete à prova de dados” antes da conversa. Proteja sua identidade digital com o mesmo cuidado com que protege suas chaves e sua casa.

Dessa forma, você poderá colher os benefícios emocionais dessa tecnologia revolucionária, mantendo a sua vida real em segurança.

Disclaimer: Este artigo oferece orientações gerais sobre segurança digital. Ele não substitui aconselhamento profissional de segurança cibernética ou terapia psicológica. Se você está passando por um momento difícil, além da IA, considere buscar ajuda de um profissional de saúde mental.